format WinWord

1

1

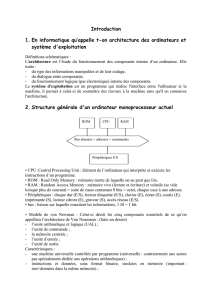

1. ASPECTS MATERIELS

1.1 Unités périphériques

1.1.1 Hiérarchie des Mémoires

Les différents éléments de la mémoire d'un ordinateur sont

ordonnés en fonction des critères suivants: Temps d'accès

Capacité et coût par bit

Quand on s'éloigne du CPU vers les mémoires auxiliaires, on

constate que le temps d'accès et la capacité des mémoires

augmentent, mais le coût par bit diminue.

- les éléments de mémoires situés dans l'unité

centrale de traitement (CPU) sont les registres

qui sont caractérisés par une grande vitesse et

servent principalement au stockage des opérandes

et des résultats intermédiaires

- L'antémémoire ou mémoire cache est une mémoire

rapide de faible capacité (par rapport à la

mémoire centrale) utilisée comme mémoire tampon

entre le CPU et la mémoire centrale. cette mémoire

permet au CPU de faire moins d'accès à la mémoire

centrale et ainsi de gagner du temps.

- La mémoire centrale est l'organe principal de

rangement des informations utilisées par le CPU.

pour exécuter un programme, il faut le charger en

mémoire centrale (instructions + données). cette

mémoire est une mémoire à semi-conducteur, mais

son temps d'accès est beaucoup plus grand que

celui des registres et du cache.

- La mémoire d'appui sert de mémoire intermédiaire

entre la mémoire centrale et les mémoires

auxiliaires. Elle est présente dans les

ordinateurs les plus évolués et permet d'augmenter

la vitesse d'échange des informations entre des 2

niveaux.

- les mémoires auxiliaires, appelés aussi mémoires

de masse (dont les mémoires d'archivage), sont des

mémoires périphériques de grande capacité et de

coût relativement faible. elles servent d'éléments

de stockage permanent et utilisent pour cela des

supports magnétiques (disque, cartouches, bandes),

et des supports optiques (disques optiques),

tandis que les niveaux les plus proches du

2

2

processeur central font appel à la technologie des

semi-conducteurs

1.1.2 Disques Magnétiques

Les disques sont des mémoires vives non volatiles.

Une unité de disques magnétiques est constitué d'un empilement de

plusieurs disques dont les 2 surfaces sont recouvertes d'une

couche magnétisable.

Les disques tournent autour d'un axe central avec une vitesse de

plusieurs milliers de tours par minute. Entre les disques se

trouvent les têtes de lecture/écriture.

La surface de chaque disque sont structurées en pistes et en

secteurs.

Les pistes sont des cercles concentriques, il y a en a plusieurs

centaines par surface.

Elles sont divisées en secteurs (de 10 à 100 par pistes) et

chaque secteur contient un certain nombre d'octets. l'ensemble

des pistes ayant un rayon donné forme un cylindre.

Les pistes d'un cylindre ont la particularité de pouvoir être

lues ou écrites sans déplacer les têtes. un disque neuf n'est pas

structuré en pistes et secteurs, il faut le formater c'est à dire

effectuer ces subdivisions.

L'accès aux informations d'un disque est un accès semi -

séquentiel. Il faut indiquer le cylindre auquel on désire

accéder, ce qui est fait directement par positionnement de

l'ensemble rigide des têtes de lecture/écriture et ensuite il

faut attendre que le bon secteur vienne sous la tête, ce qui

prend en moyenne une demi - rotation. Pour obtenir un bloc de

données, il faut spécifier l'unité de disque, le cylindre, la

surface (surface + cylindre = piste), et le secteur;

de plus il faut spécifier le nombre d'informations à transférer

et l'adresse en mémoire centrale où on doit effectuer le

transfert. Donc, pour transférer des informations, trois temps

sont à considérer :

- temps de positionnement des têtes sur le bon

cylindre

- temps d'attente, dû à la rotation du disque pour

atteindre le bon secteur

- temps de transfert des informations.

L'information est enregistrée en série sur les pistes

concentriques. Les pistes contiennent toutes le même nombre de

bits, la densité varie donc en fonction de la piste. La densité

atteint son maximum sur la piste la plus proche de l'axe central;

Les pistes sont divisées en secteurs et chaque secteur est séparé

du suivant par une petite zone non utilisée qui permet de repérer

les secteurs et de les synchroniser.

3

3

Les disques utilisent des têtes ultra - légères très proches de

la surface du disque.

L’altitude de vol des têtes (distance entre le disque et la tête

de lecture/écriture) est inférieure à 0,25 microns.

La moindre particule de poussière a une taille 10 fois plus

grande. C'est pourquoi les disques durs sont placés dans des

boîtiers hermétiques. Ces disques sont appelés disque durs et

sont fixes dans leur unité. Dans les formats les plus courants

3"1/2 ou 5"1/4, les disques ont une capacité pouvant atteindre

plusieurs gigabytes.

Les Disquettes (floppy disks) sont principalement utilisées dans

les systèmes tels que les micro-ordinateurs. elles sont

constituées d'un petit disque en matière plastique souple

recouvert d'une couche magnétisable et conservé dans une pochette

d'où il ne sort jamais.Le principe de fonctionnement est le même

que celui des disques durs.

Une nouvelle technologie des lecteurs floptiques permet de

stocker 21 mégabytes de données sur des disquettes 3"1/2. Cette

augmentation de capacité est obtenue par l'ajout d'un capteur

optique (laser) aux têtes magnétiques de lecteur/écriture qui ont

elles-mêmes gagnées en finesse. Le capteur détecte un élément de

positionnement optique placé sur une piste optique du disque, ce

qui augmente considérablement la précision de positionnement des

têtes de lecture/écriture.

1.1.3. Bandes Magnétiques

Les bandes et cartouches magnétiques sont semblables à celles

utilisées pour l'enregistrement de la musique. Elles sont

constituées d'un ruban souple servant de support à une couche

magnétisable, enroulé d'un support plastique.

caractéristiques:

* la longueur est généralement de 2400 pieds (+/-

732 m)

* la largeur d'1/2 pouce (+/- 1,27 cm)

* la bande est divisée en pistes dont le nombre est

de 7 ou 9 (la valeur 9 étant la valeur standard)

* le byte est enregistré transversalement, càd 8

bits sont répartis sur 8 pistes, la neuvième étant

utilisée pour un bit de parité

* la densité longitudinale a évolué en 25 ans de 200

à 6500 bpi

* les modes d'enregistrement utilisés sont les modes

NRZI, PE et GCR

* Le temps de lecture d'une bande est de quelques

minutes, ce sont les supports de données

relativement lents.

4

4

Les bandes/cartouches, montées sur les unités de

lecture/écriture, sont des mémoires auxiliaires, non volatiles et

à accès séquentiel.

Elles ont les avantages suivants:

* unités qui sont des périphériques standard

disponible dans la plupart des petits ou des

grands systèmes, ce qui permet l'échange de

bandes/cartouches entre systèmes.

* la méthode d'enregistrement est une méthode

très économique (1milliard de bits équivaut à

+/- 1$)

* les données peuvent être conservées sans

problèmes au moins pendant une vingtaine

d'années ( bon moyen d'archivage).

Elles ont aussi des inconvénients:

* l'accès séquentiel --> d'où une certaine lenteur

* La nécessité d'intervention d'un opérateur pour le

montage ou la démontage de la bande ou de la

cartouche dans le lecteur.

Organisation des données:

exemple d'enregistrement avec la méthode CGR:

Les informations que l'on désire stocker sont déposées dans une

mémoire tampon par groupe de 7 caractères de 8 bits + 1 bit de

parité, auxquels on ajoute un 8ième caractère de contrôle.

On divise ces 8 caractères en 2 groupes de 4. Dans chaque groupe

on obtient 9 colonnes de 4 bits que l'on code avec la table de

codage de la méthode du GCR. on enregistre ainsi des groupes de 5

bits le long de chaque piste.

Le travail de codage - décodage, contrôle, synchronisation est

transparent à l'utilisateur. il est effectué au niveau de l'unité

de bande et de son contrôleur.

Les fichiers sont composés d'enregistrement logiques

qui eux-mêmes sont composés d'un ensemble de caractères.

Sur la bande chaque enregistrement logique correspond à un bloc

physique.

Les blocs sont terminés par des bits de contrôle, appelés

Cheksum, et sont séparés par des petites zones non magnétisées

appelés Gaps. Les fichiers sont séparés par une marque de fin de

fichier.

Les cartouches ou cassettes magnétiques ( cartridges) suivent le

même principe que les bandes magnétiques, mais le format est

réduit et leur manipulation plus aisée.

5

5

1.1.4 Autres unités périphériques

1.1.4.1 DISQUES OPTIQUES

Les disques optiques numériques sont la révélation de ces

dernières années:

Ils offrent de grandes capacité de stockage sur des supports

amovibles.

Ils sont d'une très grande fiabilité;

L'inconvénient majeur est la relative lenteur de ces systèmes.

Les mémoires magnétiques présentent un certain nombre

d'inconvénient comme la sensibilité aux poussières, aux rayures,

à la température et aux champs magnétiques.

L'optique permet d'éviter ces problèmes et offre des densités

d'informations au moins 10 fois plus grandes que celles des

mémoires magnétiques, pouvant atteindre des dizaines de Mbits /

cm².

CD-ROM

sont des compacts disques enregistrés définitivement à l'usine.

Les disques compacts ont une capacité d'environ 650 Mbytes pour

un coût très bas.

On peut aussi regarder ces images sur un ordinateur ou un poste

de TV. Les Cd s'imposent donc comme le support multimédia grand

public.

L'information est stockée le long d'une spirale de microcuvettes

disposées à la surface du disque, celle-ci est revêtue d'une

couche réflective, l'ensemble étant enserré dans une couche

protectrice de résine. Lors de la lecture, on mesure la quantité

de lumière réfléchie pour reconnaître les bits 0 ou à 1.

Une cuvette diffracte la lumière et donc ne réfléchit qu'une

faible partie alors qu'en l'absence de cuvette, la lumière est

réfléchie en grande partie

les disques WORM (Write Once Read Many)

que l'on peut écrire une fois et lire autant que l'on désire, ont

constitué la première génération des médias d'archivage.

Les disques optiques utilisent un rayon laser pour la lecture et

l'écriture des données.

L'écriture est réalisée à l'aide d'un puissant faisceau laser en

creusant des petits trous ou des cuvettes dans la surface

métallique ultra - mince d'un disque en plastique. Ces

microcuvettes ont un diamètre d'environ 0,6 µm

La lecture est réalisé avec un laser moins puissant qui se

contente de détecter la présence ou l'absence des trous en des

endroits précis. Si un trou existe, la lumière émise par le rayon

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

1

/

35

100%