2.1. Caractéristiques de l`information disponible sur - Accueil

Webmaster - 1 -

Exposé MCSI 2003-2004

1

I. INTRODUCTION

La révolution mise en mouvement par les nouvelles technologies de l’information et

de la communication (NTIC) est au cœur du changement profond que connaissent les sociétés

dans tous les pays du monde ou il s’agit d’engager, sans tarder, des actions d’envergure pour

leur entrée dans l’ère de l’information et de la modernité.

Au cours de ces vingt dernières années, le monde a produit plus d’informations qu’au

cours de plusieurs siècles passés et il y a tout lieu de penser que ce processus va s’accélérer.

la société post-industrielle recèle ainsi d’immenses potentialités ouvrant la voie à des

transformations radicales programmées ou facilement prévisibles.

Le moteur de ces changements et leurs rapidités résident, à la fois, dans las applications des

sciences et des technologies, et dans les mutations sociales qui les accompagnent.

Les acquis des nouvelles technologies de l’information et de la communication ont été utilisés,

dans une première étape, dans le domaine de l’économie et celui des services. Mais les

progrès les plus importants seront réalisés à travers les technologies révolutionnaire dites

« diffusantes » comme les nouveaux matériaux, la microélectronique, la robotique, la micro

mécanique, les biotechnologies, etc.

Les nouvelles technologies interviennent désormais partout ou il sera question de

transformation de la connaissance. elle permettent en effet la mise en commun des

compétences pour parvenir à la résolution des problèmes posées par l’évolution du monde

moderne.

Au cour des dernières années, la littérature économique a mis plus précisément l’accent sur

l’impact de la diffusion des TIC sur la croissance économique. deux types de mécanismes,

pour le moins , sont alors mis en évidence. D’une part , réduisant le coût d’accès à

l’information et en améliorant la coordination des acteurs au sein de ces réseaux numériques,

l’usage des TIC contribue à dégager des gains d’efficacité d et de productivité (économies ,

d’échelles,..). d’autres part, la convergence des industries des télécommunications , de

l’informatique , de l’électronique et de l’audiovisuel a suscité l’émergence de nouvelles

activités à rendements croissants et à plus forte valeur ajoutée.

D’autres travaux se sont intéressés aux implications de la diffusion des TIC sur l’emploi et

l’organisation du travail. D’abord , d’un point de vue quantitatif , la contribution nette des

TIC en matière de création d’emplois ( soit à travers la création de nouveaux métiers , soit à

travers la transformation des métiers) se révèle positive. D’un point de vue qualitatif , en

raison du relâchement de la contrainte spatiale et temporelle induit par les TIC , l’organisation

du travail au sein des entreprises (voir des administrations ) tend à se fonder sur les principes

de la flexibilité , la décentralisation et l’autonomie.

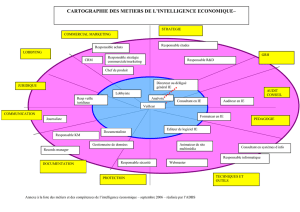

Toutes les fonctions de l’entreprise sont concernées par l’introduction des NTIC :

Les fonctions liées au management : finances, GRH, stratégies, communication,

etc.

Les fonctions techniques : toutes les opérations liées au travail technique sur les

réseaux , intra net, Internet, l’informatique, etc.

Les fonctions liées à la production : les logiciels de gestion des stocks, gestion des

approvisionnements, gestion de la qualité, etc.

Les fonctions commerciales : suivi de la clientèle, les call-centers , les

webmasters, etc..

La fonction recherche développement : le veille technologique, les innovations, la

consultation des banques de données. Etc.

Webmaster - 2 -

Exposé MCSI 2003-2004

2

II. LE World Wide Web :(WWW)

1. Définition

Le World Wide Web est né en 1989 au laboratoire physique des hautes énergies du

CERN (Centre Européen de Recherche Nucléaire) à l’initiative de Tim Bernerrs-lee…. Le

projet visait à donner au CERN un moyen de mettre en commun les recherches et les idées

avec des employés ou d’autres chercheurs dispersée dans le monde. Au début on parlait du

Web comme d’un « projet hypertexte ». Le terme hypertexte a été créé par Ted Nelson dans

les années soixante. Il désigne un texte qui contient des liens avec d’autres documents de telle

sorte que lorsque le lecteur clique sur un mot ou une phrase, il obtient de l’information

supplémentaire sur le sujet. Sur le Web on parle également de l’hypermédia. Il s’agit alors de

documents contenant des composantes multimédia. Notamment des sons et des images vidéo.

Sur le plan purement technique, le World Wide Web désigne l’interface utilisateur et

l’Internet, le réseau, c’est-à-dire le matériel constitué de câbles et d’ordinateurs. Tout ce

système repose sur l’utilisation des protocoles, séries de langages et de règles par les quels les

ordinateurs communiquent entre eux. Ainsi, le TCP/IP (pour transmission control protocol

and Internet protocol) consiste en un ensemble de protocoles de réseau permettant à différents

types d’ordinateurs de communiquer entre eux. C’est ce protocole qu’exploite internet. Le

World Wide Web n’est pas simplement un type de protocole. Il rassemble plusieurs

protocoles, notamment le protocole de transfert de fichiers FTP (pour File Transfert Protocol),

tel net, WAIS (Wide Area Information Servers, ou serveurs de données à couverture nationale)

et bien d’autres encore.

Comme le web fait appel aux protocoles normalisés d’Internet pour le transfert de fichiers et

de documents, on assimile souvent le web à l’Internet pour parler à la fois du réseau collectif

d’ordinateurs et de la masse d’information qu’il renferme.

Web n’est pas synonyme d’Internet

Beaucoup confondent ces deux termes, qu sont apparentés sans être synonyme, Internet,

issu du réseau de la défense américaine ARPANet, a vu le jour dans les années 1960. Il

s’agissait, à l’époque, de construire un réseau qui continuerait de fonctionner dans

l’éventualité où certains de ses composants seraient défaillants. Il repose sur une

infrastructure de réseau bâtie selon certaines normes, les standards Internet, qu’utilisent tous

ses membres pour se connecter entre eux. Les spécifications du protocole internent (IP) ne

précisent pas quels types d’informations, de services ou de produits doivent être échangés. IP

définit la façon dont le flux des informations est organise.

Ces spécifications résidant sur une couche située au-dessus de la couche internet. Et l’un de

ces protocoles d’échange d’informations est le World Wide Web assorti de ses protocoles de

transfert hypertexte (http). Outre le World Wide Web il existe d’autres protocoles qui

permettent aux utilisateurs de communiquer par messagerie électronique (POP3, SMTP,

IMAP), de discuter en ligne (IRC) ou de participer a des groupes de discussions (NNTP). Le

Web permet l’échange de documents via HTTP, essentiellement au format HTML qui assure

un affichage correct par les logiciels de navigation.

Le World Wide Web n’est que l’un des nombreux services existant sur Internet, et ne spécifie

pas ci une certaine page web est disponible sur intra net, extra net ou internet. Il fournit une

interface facile à utiliser et permet à des personnes connaissant peu l’informatique d’

accéder aux services Web sur tout le réseau Internet. Ces services Web concernent des

informations (contenu, en jargon Internet), des produits ou des services, qui peuvent être

consultés ou commandés à l’aide du logiciel de navigation, ou navigateur. Le navigateur Web

Webmaster - 3 -

Exposé MCSI 2003-2004

3

coïncide avec la première génération de l’Internet commercial. Il permet aux clients de faire

leurs courses sur le Web. La deuxième génération de l’utilisation commerciale de l’Internet

abandonnera l’idée de « faites-le vous même » pour celle de « faites-le pour moi ».

Ce nouveau concept de l’informatique omniprésente automatisera de nombreux processus

que les utilisateurs confient aujourd’hui aux logiciels de navigation ; mais ce n’est pas pour

demain, et les navigateurs ont encore de beaux jours devant eux.

2. Taille de World Wide Web

2.1. Caractéristiques de l’information disponible sur le World Wide Web :

Le développement rapide du World Wide Web a créé des sources d’information nouvelles et

importantes, qui rivalisent, voire remplacent celles détenues par nos grandes bibliothèques.

Néanmoins, malgré la popularité grandissante du Web, les types de documents qui y sont disponibles

sont encore mal connus. Le lancement du logiciel de navigation par Mosaic par le NCSA (National

Center for SuperComputing) en novembre 1992 est à l’origine de l’immense popularité que connaît le

Web. Au début de 1993, il n’existait que 130 sites Web sur l’Internet, mais moins de six mois après

l’apparition de Mosaic, on comptait pas moins de 10000 centres serveurs Web. John Quartrman,

ayant transmis un sondage démographique sur plus de trois millions et demi d’utilisateurs . Il y a

aujourd’hui aux alentours de 50000 sites Web dans le Web dans le monde (chiffres cités un peu

partout dans les médias).

En cinq ans, le World Wide Web est devenu une source importante pour la littérature scientifique et a

transformé radicalement la façon dont l’information est distribuée et utilisée. Les ressources

disponibles sur le Web dépassent, du moins en nombre, celles de nos grandes bibliothèques. L’an

dernier, Inktomi1 estimait qu’il y avait un total de 50 millions de documents sur le Web dont le volume

atteindrait environ un demi teraoctet. La taille du Web et sa croissance explosive qui ne montre aucun

signe de ralentissement ne laissent aucun doute sur son intérêt pour les bibliothèques et leurs

usagers.

Le World Wide Web est une forme d’accès à Internet. Utilisant des butineurs spécifiques

(comme Netscape ou Internet Explorer), les usagers peuvent avoir accès à une série de

services d’Internet. En outre, le Web dispose de son propre protocole appelé Hypertexte

Transfert Protocol (HTPP) qui permet la transmission de documents hypertextes. La souplesse

du Web et le fait qu’il puisse transmettre des documents hypertextes graphiques en ont fait le

composant d’Internet le plus populaire.

Bien que le Web soit maîtrisé techniquement, on connaît mal la nature des documents qui sont

disponibles et qui forment le Web. Une chose est claire : le Web est un ensemble de documents créés

par des auteurs et des éditeurs disposant d’un serveur Web. Le Web n’a pas de politique de sélection,

à l’inverse des bibliothèques où des décisions sont prises sur les documents qui seront acquis et

conservés dans les collections. En opposition avec les politiques d’acquisition définies par les

bibliothèques, le Web semblent être le résultat d’une campagne très réussie d’incitation aux dons, qui

inclurait le bon, le mauvais et l’horrible.

Du point de vue du contenu, le Web reste un mystère. Nous connaissons mal les sources des

documents, les types de documents disponibles, leur valeur, les langues utilisées, l’âge ou la longévité

des documents, l’étendue des sujets traités, ainsi que d’autres caractéristiques décrivant une

collection d’informations. Peu d’études ont été menées sur le contenu en raison de son instabilité et

du développement erratique du Web. General Magic2, une source de statistiques récemment utilisée

par le magazine Time3, a estimé le nombre de sites Web à 400 000 tandis que Gray4 donnait le

chiffre de 650 000.

Les usagers peuvent avoir accès au Web depuis leur bureau, leur école, leur maison et leur

bibliothèque publique quand elle propose des terminaux en accès public. Pour continuer à fournir aux

Webmaster - 4 -

Exposé MCSI 2003-2004

4

usagers une assistance de qualité en matière de recherche et d’utilisation, les bibliothèques ont

besoin de statistiques fiables décrivant la source d’information pléthorique et inestimable qu’est le

Web. Comme préliminaire à l’étude décrite ici, OCLC a fait des recherches sur le Web et dans des

documents papier pour trouver des statistiques fiables et exhaustives décrivant le contenu des pages

Web. Aucune n’a été trouvée qui puisse aider les bibliothèques et leurs usagers. Cette étude a donc

été entreprise pour modifier cette situation afin d’identifier les contenus du Web et produire des

statistiques utiles pour la communauté des bibliothèques.

Le Web utilise sa propre terminologie pour décrire le stockage, la maintenance et la diffusion

de ses documents. Les termes les plus importants pour l’étude décrite ci-dessous sont home

pages (pages d’accueil), pages Web statiques et interactives et sites Web.

2.2. Les pages Web :

L’entrée dans le Web se fait par la page d’accueil qui est à peu près équivalente à la page de

titre dans un environnement imprimé. La page d’accueil fournit généralement des

informations générales sur le site mais peut aussi fonctionner comme une table des matières.

Après la page d’accueil, l’unité bibliographique fondamentale du Web est la page Web (un

document Web, un fichier HTTP). La page Web est une entité distincte qui est identifiée par

une adresse unique appelée Uniform Resource Locator ou URL. Il y a deux types de pages

Web : statique et interactive (dynamique).

Une page Web statique est un document qui peut être lu de haut en bas sans quitter le document. A

moins qu’elle ne soit modifiée, la page Web statique présente la même information à tous les usagers.

Une page Web interactive est un document élaboré qui utilise des programmes externes pour réaliser

des fonctions spécifiques. Ces pages interactives permettent aux usagers de soumettre des

formulaires, d’interroger des bases de données, de formater des résultats, de structurer l’affichage et

d’avoir accès à des parties du site protégées par un mot de passe. Un bon exemple de site interactif

est celui de la compagnie Delta Airlines5. Plutôt que de chercher dans des tableaux d’horaires de vol

imprimés, les usagers entrent l’information nécessaire pour obtenir un document contenant

l’information pertinente (à savoir un horaire d’avion).

Un site Web est un ensemble de pages Web liées entre elles et qui sont hébergées sur un serveur

particulier.

2.3. Recueillir des extraits de pages Web

La taille imposante du Web interdit toute analyse exhaustive de son contenu. La meilleure

approche possible est le recueil d’extraits de pages Web. Cet échantillon doit être assez large

pour être représentatif de la diversité des informations du Web et assez petit pour être géré

facilement. Cet échantillon ne doit pas être biaisé afin de permettre des extrapolations sur le

Web dans son ensemble.

Le Web inclut des sites Intranet protégés par des garde-barrières (firewalls), des pages qui ne sont

consultables qu’après paiement d’une redevance, des pages qui nécessitent d’avoir une autorisation

d’accès ou tout autre moyen de restriction.

Cette étude utilise un échantillonnage de groupe dans lequel le site Web devient l’unité

d’échantillonnage et la page Web la sous-unité. L’échantillonnage de groupe est bien adapté aux

pages Web puisqu’il n’y a pas de liste des sous-unités. Un échantillon aléatoire de sites Web sera

sélectionné et les données seront prises dans chaque page Web du site.

La méthodologie de l’échantillonnage de groupe est bien expliquée par Cochran6. L’adresse IP

(Internet Protocol) sera utilisée pour identifier les sites Web. Chaque site a une adresse unique, un

identifiant numérique sur 32 bits, son adresse IP. Cette adresse est divisée en quatre octets de 8 bits

Webmaster - 5 -

Exposé MCSI 2003-2004

5

chacun, habituellement séparés par des points (ex : 132.174.1.5). Comme chaque octet est composé

de 8 bits, il peut prendre des valeurs comprises entre 8 et 255 ce qui crée 4 milliards de possibilités

d’adresses.

Chaque site Web a une adresse IP unique mais chaque adresse IP ne correspond pas à un site Web.

Plusieurs adresses IP sont associées avec d’autres services Internet comme la messagerie

électronique ou le transfert de fichiers (FTP) ; certains sites ne sont pas consultables par le public ;

certaines adresses IP n’ont pas encore été attribuées. La faible proportion d’adresses IP associées à

des services Web complique la collecte des données mais ne nuit pas à la validité de l’échantillon.

Chaque site Web a une chance équivalente d’être sélectionné dans l’échantillon. Toutefois, le nombre

de sites Web dans l’échantillon définitif sera inférieur au nombre d’adresses IP sélectionnées.

L’échantillonnage lui-même sera fait en trois temps. Tout d’abord, un échantillon aléatoire sera

constitué. Ensuite un programme automatique tentera de se connecter au port 80 (port standard pour

les serveurs W3) de chaque adresse IP pour déterminer si cette adresse a un site Web public. Enfin,

les contenus de chaque site seront collectés en déchargeant tous les fichiers HTML de ce site.

Le recueil des données débutera en juin 1997 et continuera pendant l’été. Une première analyse sera

disponible à la fin de l’été afin que des résultats détaillés soient disponibles pour la conférence. Nous

pensons que cette analyse donnera des statistiques fiables à la fois sur l’orientation thématique et les

caractéristiques de l’information disponible sur le Web.

2.4. Analyse

Les bibliothèques et la communauté des utilisateurs d’Internet ont besoin de statistiques

fiables sur la taille du Web et sur le contenu des pages Web. Ces statistiques doivent être

basées sur une méthodologie éprouvée et ayant donné lieu à des publications. Les statistiques

sont nécessaires pour :

le nombre de sites Web.

le nombre de pages Web statiques.

la taille moyenne des pages statiques.

le nombre de pages Web interactives.

La nature différente des pages Web statiques et interactives exige un traitement différent. Par

exemple, alors que l’on peut estimer la taille d’une page Web statique, la taille moyenne d’une page

interactive n’a pas de sens. En général, le service produit par une page interactive est plus important

que le texte lui-même. Une petite page interactive peut être l’équivalent de plusieurs volumes de

tableaux ou fournir un service qui n’a pas d’équivalent papier.

Ces estimations ressemblent plus à celles qui sont rassemblées par les éditeurs qu’à celles faites par

les bibliothèques puisqu’elles reflètent ce qui est publié sur le Web. Pour évaluer la nature de cette

information publiée, il faut créer des catégories de types d’information. Pour cette étude, chaque page

Web extraite de l’échantillon sera rangée sous les catégories suivantes :

Non-fiction : rapports, articles scientifiques, commentaires, essais, éditoriaux,

monographies;

Fiction/Distraction : humour, fiction, jeux, documents liés aux loisirs

Référence/Index : pages d’accueil, index, résumés, tableaux statistiques, annuaires,

profils, bibliographies, guides, information biographique/autobiographique, références

à d’autres ressources

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

1

/

69

100%