Data mining

DU Les modèles de l’Economie Numérique

3ème Promotion - 2004

Data Mining

Techniques d’extraction des connaissances

Georges El Helou et Charbel Abou khalil

Module 4.1 - Management et NTIC

Professeur : Mélissa Saadoun

Projet soutenu le 16 février 2004

Data Mining : techniques d’extraction des connaissances

Georges El Helou et Charbel Abou Khalil - 2004

2

Table des matières

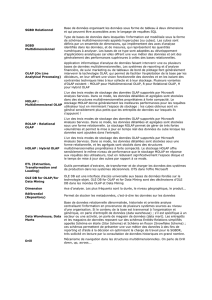

I – Du data warehouse au data mart ............................................................................. 3

I.1. COMPRENDRE LE DATA WAREHOUSE ......................................................... 3

I.1.1. HISTORIQUE .................................................................................................. 3

I.1.2. DEFINITION ................................................................................................... 4

I.1.3. POURQUOI UN DATA WAREHOUSE? ........................................................ 5

I.2. COMPOSANTS DU DATA WAREHOUSE ........................................................ 6

I.2.1. LA STRUCTURE ............................................................................................. 6

I.2.2. LES ARCHITECTURES .................................................................................. 7

I.3. LE DATA MART ................................................................................................... 8

I.3.1. MISE EN PLACE ............................................................................................. 8

I.3.2. LES SEPT MYTHES DU DATA MART ........................................................... 9

II – Les outils d’exploration et d’extraction des connaissances ................................ 10

II.1. LES OUTILS OLAP ........................................................................................... 10

II.1.1. LES 12 REGLES OLAP ................................................................................ 10

II.1.2. LES OUTILS MOLAP .................................................................................. 13

II.1.3. LES OUTILS ROLAP ................................................................................... 14

II.2. INTRODUCTION AU DATA MINING ............................................................ 16

II.2.1. PRESENTATION DU DATA MINING ......................................................... 16

II.2.2. LE DATA MINING ET LA RECHERCHE OPERATIONNELLE ................ 17

II.2.3. STATISTIQUES ET DATA MINING ............................................................ 17

II.3. LA RECHERCHE DE CONNAISSANCES ...................................................... 18

II.3.1. LES STATISTIQUES .................................................................................... 18

II.3.2. LES SCHEMAS D’INFERENCE .................................................................. 20

II.3.3. LES TACHES DU DATA MINING .............................................................. 21

II.3.4. LA CLASSIFICATION ................................................................................. 22

II.3.5. L’ESTIMATION ........................................................................................... 22

II.3.6. LA PREDICTION ......................................................................................... 22

II.3.7. LE REGROUPEMENT PAR SIMILITUDES ............................................... 23

II.3.8. L’ANALYSE DES CLUSTERS ...................................................................... 23

II.3.9. LA DESCRIPTION ....................................................................................... 23

II.3.10. L’OPTIMISATION ..................................................................................... 23

II.3.11. LE CERCLE VERTUEUX .......................................................................... 23

Conclusion ..................................................................................................................... 25

Glossaire ........................................................................................................................ 26

Bibliographie ................................................................................................................. 29

Bibliographie ................................................................................................................. 29

Data Mining : techniques d’extraction des connaissances

Georges El Helou et Charbel Abou Khalil - 2004

3

I – Du data warehouse au data mart

I.1. Comprendre le data warehouse

L’accroissement de la concurrence, l’individualisation des consommateurs et la brièveté

du cycle de vie des produits obligent les entreprises à non plus simplement réagir au

marché mais à l’anticiper. Elles doivent également cibler au mieux leur clientèle afin de

répondre à ses attentes. La connaissance de son métier, des schémas de comportement

de ses clients, de ses fournisseurs est essentielle à la survie de l’entreprise, car elle lui

permet d’anticiper sur l’avenir.

Aujourd’hui, les entreprises ont à leur disposition une masse de données importante. En

effet, les faibles coûts des machines en terme de stockage et de puissance ont encouragé

les sociétés à accumuler toujours plus d’informations. Cependant, alors que la quantité

de données à traiter augmente énormément - l'institut EDS estime que la quantité de

données collectées dans le monde double tous les 20 mois - le volume d’informations

fournies aux utilisateurs n’augmente lui que très peu. Ces réservoirs de connaissance

doivent être explorés afin d’en comprendre le sens et de déceler les relations entre

données, des modèles expliquant leur comportement.

Dans cette optique, la constitution d’un data warehouse, regroupant, sous une forme

homogène, toutes les données de l’entreprise sur une longue période, offre des

perspectives nouvelles aux utilisateurs, notamment en terme d’extraction de

connaissances grâce aux outils de data mining.

I.1.1. Historique

Le concept de data warehouse (entrepôt de données) a été formalisé pour la première

fois en 1990. L’idée de constituer une base de données orientée sujet, intégrée,

contenant des informations datées, non volatiles et exclusivement destinées aux

processus d’aide à la décision, fut dans un premier temps accueillie avec une certaine

perplexité. Beaucoup n’y voyaient que l'habillage d’un concept déjà ancien :

l’infocentre.

Mais l’économie actuelle en a décidé autrement. Les entreprises sont confrontées à une

concurrence de plus en plus forte, des clients de plus en plus exigeants, dans un contexte

organisationnel de plus en plus complexe et mouvant.

Pour faire face aux nouveaux enjeux économiques, l’entreprise doit anticiper.

L’anticipation ne peut être efficace qu’en s’appuyant sur de l’information pertinente.

Cette information est à la portée de toute entreprise qui dispose d’un capital de données

gérées par ses systèmes opérationnels et qui peut en acquérir d’autres auprès de

fournisseurs externes. Mais actuellement, les données sont surabondantes, non

Data Mining : techniques d’extraction des connaissances

Georges El Helou et Charbel Abou Khalil - 2004

4

organisées dans une perspective décisionnelle et éparpillées dans de multiples systèmes

hétérogènes. Pourtant, les données représentent une mine d’informations. Il devient

fondamental de rassembler et d’homogénéiser les données afin de permettre d’analyser

les indicateurs pertinents pour faciliter les prises de décisions. Pour répondre à ces

besoins, le nouveau rôle de l’informatique est de définir et d’intégrer une architecture

qui serve de fondation aux applications décisionnelles : le data warehouse (DW).

I.1.2. Définition

Le DW est une collection de données orientées sujet, intégrées, non volatiles et

historisées, organisées pour le support d’un processus d’aide à la décision.

Commentons cette définition :

Orientées sujet

Le DW est organisé autour des sujets majeurs de l’entreprise, contrairement aux

données des systèmes de production. Ceux-ci sont généralement organisés par processus

fonctionnels. Les données sont structurées par thème.

L’intérêt de cette organisation est de disposer de l’ensemble des informations utiles sur

un sujet le plus souvent transversal aux structures fonctionnelles et organisationnelles de

l’entreprise. Cette orientation sujet va également permettre de développer son système

décisionnel via une approche par itérations successives, sujet après sujet.

L’intégration dans une structure unique est indispensable car les informations

communes à plusieurs sujets ne doivent pas être dupliquées. Dans la pratique, une

structure supplémentaire appelée Data Mart (magasin de données) peut être créée pour

supporter l’orientation sujet.

Données intégrées

Un DW est un projet d’entreprise. Par exemple dans la distribution, le même indicateur

de chiffre d’affaires intéressera autant les forces de vente que le département financier

ou les acheteurs. Pour y parvenir, les données doivent être intégrées. Avant d’être

intégrées dans le DW, les données doivent être mises en forme et unifiées afin d’avoir

un état cohérent. Par exemple, la consolidation de l’ensemble des informations

concernant un client donné est nécessaire pour donner une vue homogène de ce client.

Une donnée doit avoir une description et un codage unique. Cette phase d’intégration

est très complexe et représente 60 à 90% de la charge totale d’un projet.

Données historisées

Dans un système de production, la donnée est mise à jour à chaque nouvelle transaction.

Dans un DW, la donnée ne doit jamais être mise à jour. Un référentiel temps doit être

associé à la donnée afin d’être capable d’identifier une valeur particulière dans le temps.

Data Mining : techniques d’extraction des connaissances

Georges El Helou et Charbel Abou Khalil - 2004

5

Données non volatiles

La non volatilité des données est en quelque sorte une conséquence de l’historisation.

Une même requête effectuée à quelques mois d’intervalle en précisant la date de

référence de l’information recherchée donnera le même résultat.

I.1.3. Pourquoi un data warehouse?

L’entreprise construit un système décisionnel pour améliorer sa performance. Elle doit

décider et anticiper en fonction de l’information disponible et capitaliser sur ses

expériences.

Depuis plusieurs dizaines d’années, une importante masse d’informations est stockée

sous forme informatique dans les entreprises. Les systèmes d’information sont destinés

à garder la trace d’événements de manière fiable et intègre. Ils automatisent de plus en

plus les processus opérationnels.

Parallèlement, les entreprises réalisent la valeur du capital d’information dont elles

disposent. Au delà de ce que l’informatique leur apporte en terme fonctionnel, elles

prennent conscience de ce qu’elle pourrait apporter au niveau du contenu

informationnel.

Considérer le système d’information sous cet angle en tant que levier pour accroître leur

compétitivité et leur réactivité n’est pas nouveau. Par contre, étant donné

l’environnement concurrentiel actuel, cela devient une question de survie.

L’informatique a un rôle à jouer, en permettant à l’entreprise de devenir plus

entreprenante et d’avoir une meilleure connaissance de ses clients, de sa compétitivité

ou de son environnement.

Il est intéressant de calculer les retours sur investissement rendus publics. Ils se

calculent rarement en terme de baisse de coûts, mais en terme de gains. Par exemple, ils

permettent un meilleur suivi des ventes, une meilleure compréhension des habitudes

d’achats des clients, d’une adaptation des produits à une clientèle mieux ciblée.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

1

/

29

100%