Architectures parallèles

«L’architecture SIMD »

Dr HALFAOUI Fadhila

Université Alger 1

Faculté des sciences

Département Informatique

2ème année Master RSE

2022/2023

1

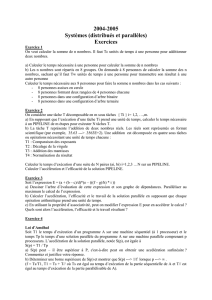

Définition et architecture

L’architecture SIMD est une architecture dont toutes les unités de

traitement exécutent le même flux d’instructions qui opèrent sur des flux

de données différents,

Ce modèle est l’un des premiers modèles d’architecture parallèle,

UC

UT1

UT2

UT3

ML

Flux d’instructions Flux de données

UC Unité de contrôle

UT Unité de traitement

M Mémoire locale

ML

ML

Chaque processeur exécute la même opération que les autres mais sur des

données différentes.

Chaque processeur possède une petite mémoire locale.

Ce modèle convient principalement pour des calculs numériques réguliers

(comme le traitement d’images).

Exemples : Cray-1 (1976), NEC SX-5, Tera/Cray SV1, Connection Machine CM -

1(1985),…

Actuellement GPUs (processeur graphique)

L’architecture SIMD

L’architecture SIMD est désormais utilisée essentiellement pour des applications très

spécialisées.

Le modèle SIMD a tiré sa popularité de sa simplicité pour le programmeur et pour

l’architecte et le constructeur de machine.

Le modèle SIMD n’exploite que le parallélisme de données.

Il s’agit d’appliquer la même opération à une très grande quantité d’informations -

Machines spécialisées dans les traitements des tableaux (ARRAY Processors).

Modèle d’exécution fortement synchrone.

L’architecture SIMD

Caractéristiques

Une seule unité de contrôle,

Plusieurs unités de traitement,

Registres et mémoires locale

Les unités de calcul totalement synchronisées.

Un seul cycle d’horloge par traitement et un seul compteur ordinal.

Une instruction unique contrôle l’exécution simultanée de plusieurs éléments de

calcul.

Les unités d’exécution parallèles sont synchronisées et chaque unité a son propre

registre d’adresses,

Les processeurs vectoriels sont souvent considérés comme des architectures de

type SIMD.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

1

/

23

100%

![+ A[i] tS[1]](http://s1.studylibfr.com/store/data/003362329_1-fe10d47d2180aff5a5a8b77c63531192-300x300.png)