Analyse Quantitative des Données : Cours Universitaire

Telechargé par

ninssemondstephane

StuDocu is not sponsored or endorsed by any college or university

Analyse quantitative des données

Analyse quantitative des données (Université de Paris-Cité)

StuDocu is not sponsored or endorsed by any college or university

Analyse quantitative des données

Analyse quantitative des données (Université de Paris-Cité)

Downloaded by Stephane Pouho ([email protected])

lOMoARcPSD|18427511

Analyse quantitative des données

Chapitre 0 : Brève introduction aux méthodes statistiques inférentielles

Résume ce que l’on a

Statistiques inductives : Vérifier que la décision marche sur toute la population et non pas seulement

l’échantillon observé

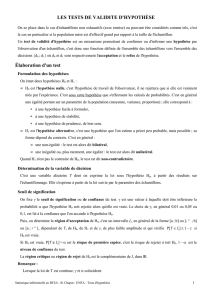

On veut savoir si une certaine hypothèse que je me pose, (par exemple ½ enfant a peur du noir, les

filles réussissent mieux que les garçons etc…) que l’on va noter H, est vrai ou non dans une

population que je vais noter P. On ne dispose que d’un échantillon extrait (au hasard) de cette

population.

P Echantillon observé

X x x x

H ? xxx x H1 x

X x

Si H1 est vraie dans l’échantillon peut-on dire que H1 est vraie dans P ?

Ces méthodes que l’on va étudier, associe automatiquement l’hypothèse H1 que l’on veut

vérifier/valider, on lui associe toujours une hypothèse qui H0 qui contredit H1 dite « hypothèse

nulle ». On veut tester H1 contre H0, laquelle choisir ?

è On dispose d’une formule qui est dites statistique du test, laquelle est simplement une

formule. C’est une machine qui a un échantillon, qui a un échantillon va associer (calculer)

une valeur numérique.

Notons, pour l’instant, T cette formule

è Cette statistique T a été construite de telle sorte que l’on connaît sa loi des probabilités si H0

était vrai dans la population. (Je peux faire des prévisions avec des probabilités que cette

formule T donnera, par exemple, un score inférieur à 3)

On peut calculer toutes probabilités (choses) liés aux valeurs possibles de cette formule T.

è On construit une zone ou région que l’on va nommer R, c’est une zone ou région de valeurs.

(souvent un intervalle ou réuni en intervalles) Cette région a été construite de telle sorte que

si H0 était vraie dans la population P alors on aurait peu de chance que les valeurs de T

tomberaient dans la région R.

(ⱷ=Alpha psk je trouve pas le vrai signe)

Proba (T soit dans R) = ⱷ petite proba si H0 était vraie

Ou encore que T aura une grande chance de donner une valeur en dehors de cette R.

Proba(T soit en dehors de P) = 1-ⱷ =grande proba

Downloaded by Stephane Pouho ([email protected])

lOMoARcPSD|18427511

Par exemple : Zone R

T serait ici T ne serait pas ici

Avant même sondage, on « sait que » si H0 était vraie.

- On établit alors la règle de décisions suivante :

On calcule T sur notre échantillon soit T observé = la valeur calculée

Si Tobs dans la zone R on rejette H0 pour accepter H au risque ⱷ de se tromper car notre

échantillon contredit/ n’est pas compatible à 100% avec H0

- Si Tobs est en dehors de cette région R, on ne peut pas rejet H0 pour accepter H1 car notre

échantillon ne contredit pas H0. (Cependant ce n’est pas parce que j’ai vu que H0 n’est pas

compatible je n’ai ni la preuve qu’elle est fausse ni qu’elle est vraie)

- La zone R est dite région de rejet de H0 (cad d’acceptation de H1)

Il y a deux façons de prendre la mauvaise décision en utilisant cette technique statistique

è Dire que H0 est fausse (cad dire H1 vraie) alors qu’en réalité H0 est vraie

è Dire que H0 est vraie alors qu’en réalité H0 est fausse

Décision prise/ Etat réel de H0

H0 fausse

H0 vraie

H0 fausse

Bonne décision

Mauvaise décision risque ⱷ de

1ère espèce

H0 vraie

Mauvaise décision, risque B

(Béta) de 2ème espèce

Bonne décision

ⱷ = Proba que notre test statistique nous mène à dire que H0 est fausse (valider H1) alors que H0

vraie (H1 fausse)

1-ⱷ = Proba de dire (avec ce test) que H0 est vraie et il se trouve que H0 est vraie = niveau de

confiance du test

B = Proba de dire que H0 est vraie alors qu’en réalité H0 est fausse

= Erreur ou risque de se tromper de 2ème espèce

1-B = Proba de dire que H0 fausse lorsque H0 est fausse réellement fausse

Seul l’erreur ⱷ pourra être calculée et parfaitement contrôlée dans tout ce qu’on va faire.

L’erreur B est très souvent difficile (voire impossible) à calculer même si il existe des techniques pour

l’estimer ou le majorer (ceci est dû à la structure souvent vague de H1)

Pour retenir la notion de ces erreurs ⱷ et B

Supposons que pour déceler la présence d’une certaine maladie M, on dispose d’un test médical T

qui n’est pas efficace à 100% (comme la majorité des tests médicaux)

Ou :

- α= Proba que notre test statistique nous mène à dire que H0 est fausse ( valider H1 )

alors que H0 est vraie ( H1 fausse ) = risque de 1ère espèce

- 1 – α = Proba de dire ( avec ce test ) que H0 est vraie et il se trouve que H0 est vraie =

niveau de confiance du test

- β= Proba de dire que H0 est vraie alors qu’en réalité H0 est fausse = erreur ou risque

de 2nd espèce

Downloaded by Stephane Pouho ([email protected])

lOMoARcPSD|18427511

- 1 – β = Proba de dire que H0 est fausse lorsque H0 est réellement fausse, seule

l’erreur α pourra être calculée est parfaitement contrôlée. L’erreur B est très souvent

difficile (voir impossible ) à calculer = la puissance du test utilisé

- Même s’il existe des techniques pour l’estimer ou le majorer (ceci est dû à la

structure souvent vague de H1 )

Ce test T a été élaboré de telle sorte que :

- Le T appliqué à 100 vrais atteint par M (maladie), ce test est positif dans 95% des cas. 5% lui

échappe.

- Le T appliqué testé sur 100 vrais non atteint par M, ce test est négatif sur 90% de cas. 10%

Résultat T/ Etat

M présente

Non M

Notons H1 = présence

de M

H0 = pas de M

Calculer le ⱷ, (1- ⱷ)

Le B et le (1-B) pour ce

test T

Positif T+

95

10

Négatif T-

5

90

Total

100

100

ⱷ = Proba (dire qu’un patient est malade alors qu’en réalité il n’est pas malade)

= Proba de lire T+ sur un patient qui n’est pas malade.

-------------------

Ici, dans cet exemple

H1 « Présence de la maladie M » H0 : « Absence de Maladie M »

ⱷ Proba que mon test dise que M est présent alors qu’en réalité M est absent (M-)

ⱷ = 10/100 = 0,10 (10%) = risque de 1ère espèce pour ce test T

1- ⱷ = 90/100 = proba que T dise Absence M lorsque M est réellement absente (M-)

= niveau de confiance accordé à ce test T

B= Proba que le test dise M absente (T-) alors qu’en réalité M est présente (M+)

= 5/100 = 0,05 (5%)

= Risque de 2ème espèce

(1-B) = Proba que T dise présence M càd T+ lorsque M est présente M+

è Puissance de ce test. = 95/100 = 0,95 (95%)

Chapitre 1 : Estimations et intervalles de confiance pour des pourcentages ( proportions)

inconnues :

1) Estimation ponctuelle :

Downloaded by Stephane Pouho ([email protected])

lOMoARcPSD|18427511

On s’intéresse à un certain caractère C dans une population P donnée

On s’intéresse donc à une variable qualitative ( ou nominale ) à 2 modalités : A = { C ; non C }

On notera : p = proportion de C dans P

p= nombres d’individus de (P) qui ont C / nombre total d’individus dans (P)

( 1-p) = proportion de non C dans (P)

La proportion p (et donc (1-p) aussi) est inconnue. On souhaite ainsi avoir des « informations » sur

cette proportion inconnue p

On ne dispose que d’un échantillon …. ?

On observe dans cet échantillon :

- K sujet qui ont le caractère C

- N-k sujets n’ont pas le caractère C

On notera

F=proportion de C dans notre échantillon

F=k/n

(1-f) = prop. De nm C dans l’échantillon

(1-f) = n-k/n

Echantillon

K C

En prop f

n-k non C en pop (1-f)

1/3 = 0,33

On démontre qu’une « bonne façon » d’estimer la valeur exacte de la proportion p inconnue est

d’utiliser la proportion f observée dans notre échantillon

On dira que f = une estimation ponctuelle de p

/!\ Lorsqu’on dit que f est une « bonne estimation » de p ça ne veut pas dire que forcement f est une

« bonne approximation » (distingué le sens de approximation et estimation)

On ne sait pas, pour l’instant, si f est proche de p, ou si f est très éloignée de p !

« Bonne estimation » veut dire simplement que la proportion f observée dans l’échantillon est la

valeur f observée dans l’échantillon est c’est avec cette valeur qu’on aura le plus de chance de

s’approcher au mieux de p.

En effet… (si l’on imagine avant sondage)

Si on note F la proportion du caractère C dans un échantillon de taille n que le hasard va nous donner

Downloaded by Stephane Pouho ([email protected])

lOMoARcPSD|18427511

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

1

/

16

100%