Apprentissage automatique pour le diagnostic des éoliennes offshore

Telechargé par

Town of Photography

Rapport de Stage de Fin d’Etudes

Présenté par :

Mahamadou Klanan Diarra

Parcours Ingénierie mathématique

Majeure Ingénierie Mathématique Pour l’Entreprise

06 mai - 31 octobre, 2019

Machine learning pour le diagnostic

des éoliennes offshore

INSA ROUEN, Laboratoire d’Informatique, de

Traitement de l’Information et des Systèmes

(LITIS)

Directeur de stage : Prof. Gilles Gasso

Sorbonne Université - Paris 6

Table des matières

1 Introduction 2

2 Contexte du stage 4

2.1 SiemensGamesa ............................... 4

2.2 Environnement de travail . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.3 Éolienne : histoire et fonctionnement . . . . . . . . . . . . . . . . . . . . 5

2.4 Formulation du problème . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3 Déroulement du stage 10

3.1 Problématiquedustage............................ 10

3.2 Bibliographie ................................. 10

3.3 Implémentation&Test............................ 11

4 Études des modèles 12

4.1 Préambule................................... 12

4.2 Kernel change detection . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

4.2.1 Oneclasssvm............................. 14

4.2.2 Algorithme du kernel change detection . . . . . . . . . . . . . . . 17

4.3 Discrépance moyenne maximale (maximum mean dicrepancy MMD) . . 20

4.3.1 MMD dans un espace de Hilbert à noyau reproduisant . . . . . . 21

5 Évaluation 24

5.1 Données .................................... 24

5.1.1 Feature extraction . . . . . . . . . . . . . . . . . . . . . . . . . . 26

5.2 Test sur des lois de probabilités . . . . . . . . . . . . . . . . . . . . . . . 26

5.3 Test sur des données simulées d’éoliennes . . . . . . . . . . . . . . . . . . 28

5.3.1 Pré-traitement des données . . . . . . . . . . . . . . . . . . . . . 28

5.3.2 Stratégie de mise en œuvre . . . . . . . . . . . . . . . . . . . . . . 29

5.3.3 Résultats ............................... 32

6 Conclusion 37

A Annexes 39

1

Table des figures

1.1

La part de l’éolien dans la production d’électricité en France en 2017 et

dans le monde en 2016. Ces représentations sont issues du site internet

d’EDF...................................... 2

2.1 Moulin-cabine à corps mobile. Robert Philippe (1982)[2] ........ 6

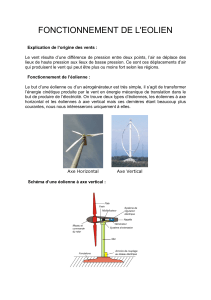

2.2 Différentes parties d’une éolienne[3] ..................... 7

2.3

A droite la nacelle d’une éolienne onshore. Sa particularité est qu’elle munie

de boite de vitesses car le générateur plus petit est placé à l’intérieur de la

nacelle contrairement à une éolienne offshore dotée d’un plus gros générateur

placé entre le rotor et la nacelle. Les éoliennes offshore de Siemens Gamesa

ne sont pas munies de boites de vitesses . . . . . . . . . . . . . . . . . . . 8

4.1

Illustration du transfert des données non linéairement séparable via la

fonction Φ(·) aussi appelée feature map . . . . . . . . . . . . . . . . . . . 13

4.2 Illustration du OC-SVM . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

4.3

Les données sont telles que

k

(

xi, xi

) =

c

. Trouver l’hyperplan est équivalent

à trouver la sphère de rayon minimale qui entoure une certaine proportion

des données. Cette illustration est extraite du livre

Learning with kernels

(voir référence [1], p. 234) . . . . . . . . . . . . . . . . . . . . . . . . . . 16

4.4

Influence des paramètres

ν

et

γ

sur la région estimée par le OC-SVM. Les

points rouge sont en dehors de la région et sont jugés atypiques . . . . . 17

4.5

Principe de la fenêtre glissante, on veut tester la présence d’un changement

à partir de

xt

. Cette illustration est extraite du papier

An online kernel

change detection algorithm. (voir référence [2], p. 3) . . . . . . . . . 18

2

4.6

Illustration du OC-SVM correspond aux deux fenêtres d’observations. Cette

illustration est extraite du papier

An online kernel change detection

algorithm. (voir référence [2], p. 8) . . . . . . . . . . . . . . . . . . . . . 19

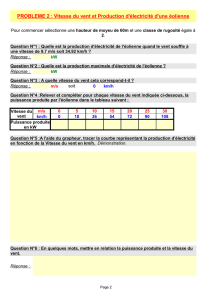

5.2

Accélérations de la nacelle et des pales. Cet exemple simule un changement

devitesseduvent. .............................. 24

5.1

Vibration latérale de la pale. Cette vibration entraîne celle de la nacelle

lorsque la pale est aligné suivant l’axe de l’éolienne. . . . . . . . . . . . . 25

5.3 Fréquencesdespales ............................. 25

5.4 Donnéessimulées ............................... 27

5.5

Graphiques des tests réalises sur des simulations de différentes lois de

probabilités comparées à la loi normale centrée réduite . . . . . . . . . . 27

5.6

Pré-traitement : la figure de gauche représente les signaux d’entrées, celle

de droite les signaux de sorties . . . . . . . . . . . . . . . . . . . . . . . . 29

5.7

Illustration de la stratégie de détection : les rectangles représentent les

spectrogrammes des 3 pales,

At,N

,

Bt,N

et

Ct,N

représentent les sous matrices

de N colonnes prélevées sur les spectrogrammes respectivement à l’itération

t

.

30

5.8 Les Spectrogrammes des signaux pré-traités . . . . . . . . . . . . . . . . 31

5.9

KCD : le graphique de gauche représente les comparaisons des pales deux

à deux, celui de droite la moyenne . . . . . . . . . . . . . . . . . . . . . . 31

5.10

MMD : le graphique de gauche représente les comparaisons des pales deux

à deux, celui de droite la moyenne . . . . . . . . . . . . . . . . . . . . . . 32

5.11

Accélérations et fréquences des pales, défaut sur la pale B à partir de 5400.0.

Le défaut s’amplifie progressivement. . . . . . . . . . . . . . . . . . . . . 34

5.12 Signaux pré-traités à gauche, spectrogrammes à droite . . . . . . . . . . 34

5.13 KCD à gauche, MMD à droite. La ligne rouge représente le seuil. . . . . . 34

5.14 Accélérations et fréquences, défaut : 11000 . . . . . . . . . . . . . . . . . 35

5.15Spectrogrammes................................ 35

5.16 Gauche : KCD, droite : MMD . . . . . . . . . . . . . . . . . . . . . . . 35

3

5.17 Accélérations et fréquences test 3, défaut : 5400 . . . . . . . . . . . . . . 36

5.18Spectrogrammes................................ 36

5.19 Gauche : KCD, droite : MMD . . . . . . . . . . . . . . . . . . . . . . . 36

1

Exemple d’utilisation, les points noirs sont tirés d’une distribution normale

centrée et réduite, les points violets quant à eux sont d’une distribution

normale de moyenne (1,1) mais de même variance. La mesure calculée est

affichée en bas du graphe. . . . . . . . . . . . . . . . . . . . . . . . . . . 44

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

1

/

53

100%